Tenho a sensação de que quase ninguém viu, mas foi publicado agora no final de dezembro um artigo na The Lancet Regional Health – Americas que se propõe a refutar o meu artigo com Beny Spira analisando a relação entre uso de máscaras e mortalidade em excesso durante a pandemia de Covid em 24 países europeus. Nós ficamos sabendo a respeito do artigo no dia 31/dezembro através de um e-mail de uma jornalista do Jornal da USP que nos pedia para comentar. Uma matéria foi então publicada no Jornal da USP no dia 06/janeiro. Em seguida, o Estadão divulgou a matéria do Jornal da USP em suas redes sociais e depois a Folha de São Paulo fez a sua própria reportagem.

Eu não vou gastar espaço aqui comentando as reportagens porque obviamente não era de se esperar que elas fossem boas e equilibradas. Para a surpresa de essencialmente ninguém, a narrativa que está sendo construída por esses meios de comunicação vai na linha de que os cientistas bons refutaram o artigo daqueles negacionistas (eu e o Beny) que tinham feito um estudo ruim cujas conclusões contrariam o consenso científico – e agora todos podem dormir tranquilos, já que o artigo dos negacionistas está morto e enterrado e a Ciência venceu mais uma vez. As reportagens têm tido quase nenhuma repercussão em redes sociais e acho que estou fazendo um favor aos jornais de citá-los aqui – sim, este post possivelmente terá mais visibilidade do que os jornais. Se alguém quiser ler a nossa entrevista ao Jornal da USP na íntegra e não apenas o que foi publicado, estão disponíveis aqui as perguntas enviadas pela jornalista e as nossas respostas.

O que eu quero discutir aqui é o artigo que pretende nos refutar. Como este vai ser um post longo que pouca gente vai ter paciência de ler até o final, deixo logo de cara o TLDR: o artigo não para em pé e eu e Beny escrevemos um pedido de retratação para a revista. O documento técnico que embasa o pedido está linkado aqui (veja também aqui para os gráficos de resíduos citados no texto).

Obviamente, não sabemos como a revista vai reagir. Minhas expectativas de que a revista tome a decisão baseada em critérios técnicos é baixa, mas dado que os problemas com o artigo são muito gritantes, a revista pode acabar atendendo o pedido de retratação para não passar muita vergonha. Veremos.

Como muita gente que vai ler este texto não faz muita ideia do que está acontecendo e no máximo ouviu boatos, é necessário antes de mais nada dar um pouco de contexto.

1. O contexto

No início de março de 2025, eu e Beny Spira do ICB-USP publicamos um artigo na revista BMC Public Health analisando a relação entre uso de máscaras e mortalidade em excesso durante a pandemia (mais precisamente, anos 2020 e 2021) em 24 países europeus. Nós encontramos uma relação positiva (e estatisticamente significativa) entre uso de máscaras e mortalidade em excesso, i.e., mais máscaras, mais mortes. A análise é ajustada por alguns potenciais fatores de confusão (usando uma regressão múltipla).

Pouco depois disso, a publicação do estudo foi noticiada pela Revista Oeste e logo viralizou nas redes sociais que um “estudo da USP mostrava que as máscaras não ajudaram na pandemia”. Agências checadoras de fatos [veja aqui, aqui e aqui] e até o Ministério da Saúde se apressaram em convocar pessoas (não necessariamente qualificadas para opinar) para dizer como o nosso estudo era ruim e não provava nada. Eu estava com pouco tempo para escrever em redes sociais à época, mas escrevi uma breve manifestação no meu Facebook.

Por se tratar de um estudo observacional e, mais especificamente, de um estudo ecológico (vide seção 2 abaixo se você não sabe o que é isso), nosso estudo confere um nível de evidência mais fraco às suas conclusões do que os estudos randomizados, que figuram no mais alto nível da hierarquia de evidências. Certamente é fácil listar limitações do nosso estudo e nós mesmos fizemos isso no nosso artigo. Nossas conclusões são modestas. O discurso apresentado para o grande público de que o nosso estudo “não comprova” a ineficácia das máscaras é correto, porém enganoso. Infelizmente o grande público tem uma ideia errada de que estudos às vezes “comprovam” certas coisas, mas não é assim que a Ciência funciona. Estudos produzem evidências para certas teses que podem ser de maior ou menor qualidade.

O fato crucial que foi omitido na discussão pública é que a metanálise da Cochrane que agrega os resultados dos estudos randomizados sobre uso de máscaras evidencia justamente que elas não são capazes de reduzir a transmissão viral ou no máximo têm um efeito pequeno. Em outras palavras, os estudos que produzem o mais alto nível de evidências não dão suporte à efetividade das máscaras para conter a transmissão. Os defensores das máscaras tendem a minimizar a importância das conclusões da metanálise da Cochrane (mais sobre isso na seção 3 abaixo) e justificam sua crença de que as máscaras funcionam recorrendo a estudos de qualidade inferior: estudos observacionais, ecológicos ou pior – estudos que nem sequer envolvem comparações entre incidência de infecção em seres humanos usando ou não máscaras (tais como testes de laboratório da capacidade de filtragem do material de cada tipo de máscara).

Dessa forma, nosso estudo acabou se tornando um espantalho conveniente para os defensores das máscaras. É fácil bater nele e isso desvia a atenção do que realmente importa – a metanálise da Cochrane na qual é difícil de bater. O nosso estudo não é “o estudo que mostrou que as máscaras não funcionam”, isso já havia sido “mostrado” antes por estudos de melhor qualidade. O que o nosso estudo traz de novo é informação sobre a relação positiva entre uso de máscaras e mortalidade – algo que estudos randomizados não tem condição de avaliar por limitações de tamanho amostral (mortes são mais raras do que infecções e por isso você precisa de amostras muito maiores para avaliar o efeito na mortalidade). A associação que encontramos certamente não comprova que as máscaras aumentaram a mortalidade, nunca afirmamos isso, mas sim traz alguma evidência dessa possibilidade que precisa de (muito) mais evidências para ser confirmada.

Após a viralização da notícia sobre o nosso estudo, defensores das máscaras se organizaram para enviar cartas à revista BMC Public Health pedindo a retratação do artigo. Algo similar ocorreu quando a Cochrane divulgou a última versão da sua metanálise em 2023: defensores das máscaras pressionaram a entidade para alterar as suas conclusões. Trata-se de um grupo fanático, obstinado, barulhento e eficaz em fazer pressão política. Ao final, a Cochrane não alterou as conclusões da metanálise. Nosso estudo também não foi retratado. Para minha surpresa, a revista foi razoavelmente séria e não cedeu às pressões. Insistiram em pequenas mudanças de redação em alguns trechos do texto que não fazem realmente diferença. Claro que isso foi usado por alguns comentadores para criar uma narrativa de que “fomos obrigados a corrigir o artigo” e que “haveria erros sérios”, mas não é verdade.

Cabe comentar também que foi muito dito por aí que o nosso estudo encontrou uma “mera correlação” e isso não é verdade. Mera correlação significa de fato quase nada, mas o que encontramos é uma associação (estatisticamente significativa) que persiste após várias tentativas de ajuste por variáveis de confusão (através de regressão múltipla). Isso é bem mais do que “mera correlação”, embora seja também bem menos do que uma demonstração de causalidade.

2. Estudos randomizados, observacionais, ecológicos e tudo isso

Explico rapidamente aqui o significado de certos termos para quem não sabe. O nosso estudo é do tipo observacional: pegamos dados do mundo real e avaliamos associações entre variáveis (no caso, uso de máscaras e mortalidade) usando métodos estatísticos para controlar variáveis de confusão. Isso é diferente de um estudo randomizado em que se avalia o efeito de uma intervenção num desfecho previamente escolhido selecionando de forma aleatória quais indivíduos receberão ou não a intervenção – nesse caso é a aleatoriedade da seleção de quem recebe a intervenção que tem o papel de evitar a interferência de variáveis de confusão.

Via de regra, estudos randomizados produzem evidências de qualidade superior a estudos observacionais. Um dos motivos para isso é que não sabemos a priori quais são todas as possíveis variáveis de confusão para fazer um ajuste. Além do mais, os métodos de ajuste possuem suas próprias limitações e os dados de mundo real têm frequentemente pior qualidade do que dados coletados no contexto de um estudo controlado.

O nosso estudo é também do tipo ecológico: isso significa que avaliamos dados agregados de grupos populacionais. Em vez de comparar a mortalidade com o uso de máscaras em indivíduos, olhamos para os totais de países. Via de regra, estudos ecológicos produzem evidências de qualidade inferior a estudos observacionais que usam dados de indivíduos. Isso se deve ao fato que os dados agregados não captam de forma adequada a complexidade da estrutura interna de grupos populacionais.

Normalmente se diz que estudos observacionais (em particular, os ecológicos) não são capazes de comprovar causalidade. Diz-se também que afirmações a respeito de indivíduos baseadas em estudos ecológicos incorrem na chamada falácia ecológica. Essa linguagem é um tanto enganosa porque (correndo o risco de ser repetitivo) estudos não são argumentos lógicos que provam teses como se fossem demonstrações matemáticas. Os estudos randomizados também têm limitações e não comprovam causalidade – ocorre que os estudos observacionais têm mais limitações (como a possibilidade de variáveis de confusão não ajustadas) e provém evidência mais fraca (porém não nula) de relação causal. Estudos ecológicos, ao ignorarem a distribuição interna das variáveis relevantes dentro de grupos populacionais, produzem evidência ainda mais fraca do que estudos observacionais que usam dados de indivíduos, porém reconhecer que essa evidência é superior a nenhuma evidência não é uma falácia.

3. A metanálise da Cochrane e como os defensores das máscaras minimizam suas conclusões

Estudos não produzem conclusões binárias do tipo “essa intervenção funciona” ou “essa intervenção não funciona”. Eles produzem estimativas de tamanho de efeito de uma intervenção e também uma margem de erro para essa estimativa, normalmente apresentada na forma de um intervalo de confiança de 95%. Esse intervalo de confiança é calculado usando um procedimento que, sob condições ideais, faz com que o verdadeiro tamanho do efeito esteja dentro desse intervalo em 95% dos estudos. Quando o efeito nulo está fora do intervalo de confiança, diz-se que o resultado foi estatisticamente significativo e isso é frequentemente apresentado como comprovação de eficácia. Essa “comprovação” não é de fato uma comprovação já que, mesmo sob condições ideais, em 5% dos estudos o intervalo de confiança não conterá o verdadeiro tamanho do efeito. Além do mais, há outras fontes de incerteza em resultados de estudos além daquela expressa pelo tamanho do intervalo de confiança. Mesmo estudos randomizados não são perfeitos.

Quando o resultado de um estudo não é estatisticamente significativo, i.e., quando o efeito nulo está dentro do intervalo de confiança, alguns comentadores reportam o resultado como “evidência de ineficácia” ou até “comprovação de ineficácia”. Esse infelizmente é um erro comum e víamos isso na pandemia o tempo todo quando se falava de eficácia de tratamento precoce. Falta de significância estatística pode ocorrer, por exemplo, com uma estimativa de tamanho de efeito grande junto de um intervalo de confiança também grande. Nesse caso, temos apenas muita incerteza sobre o tamanho do efeito e não evidência de que ele seja pequeno ou nulo. À medida que novos estudos são feitos e temos mais dados disponíveis, podemos agregá-los numa metanálise e obter uma estimativa de efeito mais precisa, com um intervalo de confiança menor. É comum acabarmos encontrando um resultado estatisticamente significativo combinando vários resultados que não são estatisticamente significativos individualmente. Por isso é incorreto classificar resultados sem significância estatística como “negativos”.

É possível comprovar ineficácia de uma intervenção? Por mais dados que tenhamos, sempre há uma margem de erro na estimativa de tamanho de efeito e portanto não podemos afirmar que ele é nulo. O mais próximo de “comprovação de ineficácia” que podemos ter após um estudo ou metanálise é uma estimativa de tamanho de efeito pequena junto de um intervalo de confiança também pequeno. Isso é o que a metanálise da Cochrane reporta na comparação entre máscaras cirúrgicas e ausência de máscaras: estimativa de 5% com intervalo de confiança indo de -9% a 16% (para o desfecho Influenza/Covid-like illness – há resultados com incerteza maior para outros desfechos). Na comparação entre máscaras N95 e máscaras cirúrgicas, o resultado é mais favorável às máscaras N95 e as incertezas são maiores: estimativa de 30% com intervalo de confiança que vai de -10% a 55% (para o desfecho clinical respiratory illness).

No entanto, como explicado acima, há outras fontes de incerteza sobre os resultados de um estudo além daquelas expressas no intervalo de confiança, mesmo no caso de estudos randomizados. Em metanálises isso é expresso através de uma tabela que avalia qualitativamente o risco de viés de cada estudo incluído. Metanálises padrão Cochrane fazem normalmente uma análise rigorosa desse risco de viés e isso influencia a linguagem usada para expressar as conclusões. A conclusão da metanálise não vai dizer que “a intervenção não funciona”, vai expressar uma conclusão com linguagem mais cautelosa dependendo do tamanho do intervalo de confiança e do risco de viés dos estudos incluídos (e também de outros fatores, como a heterogeneidade dos estudos).

Os defensores das máscaras exploram a linguagem cautelosa da Cochrane, que leva em conta mesmo o risco de viés de estudos randomizados imperfeitos, para minimizar a importância de suas conclusões enquanto usam estudos observacionais, ecológicos (ou pior) com um risco de viés muito maior para defender que as máscaras são comprovadamente eficazes.

4. O problema da causalidade reversa

Um ponto que foi frequentemente levantado desde a publicação do nosso estudo é a possibilidade de que a associação que encontramos entre uso de máscaras e mortalidade seja explicada pela causalidade no sentido reverso: não é a intervenção causando o desfecho, mas o desfecho causando a intervenção, i.e., nos países em que a pandemia foi mais letal as pessoas tendiam a usar mais máscaras como resposta à letalidade da pandemia. Os primeiros que levantaram essa possibilidade foram nós mesmos, no nosso próprio artigo. No nosso suplemento incluímos gráficos comparando a evolução temporal de uso de máscaras e de mortalidade Covid em cada um dos 24 países. Avaliando esses gráficos chegamos à conclusão de que essa causalidade reversa provavelmente não é relevante. Obviamente isso não é uma comprovação de que a causalidade reversa não existiu, é uma análise informal visual a partir de gráficos.

Os gráficos comparando mascaramento e mortalidade sugerem que em muitos lugares houve uma redução de mascaramento (de magnitude variável, dependendo do lugar) nos intervalos entre as grandes ondas de infecção. No entanto, esses intervalos entre as grandes ondas ocorrem em todo lugar e, grosso modo, as grandes ondas de infecção ocorrem aproximadamente nas mesmas épocas nos vários países europeus (parecem estar associadas a estação, chegada de novas variantes e redução da imunidade natural). Já a letalidade das grandes ondas é bem variável (varia com a onda e o país) devido a uma quantidade grande de fatores e a questão central que se coloca é se ondas mais letais tendem a gerar mais mascaramento como reação. Uma inspeção dos gráficos sugere que esse não é o caso.

Uma possível estratégia para lidar de modo mais formal com o problema da causalidade reversa seria fazer um novo estudo que leva em conta a evolução temporal das variáveis relevantes: mortalidade em excesso, mascaramento e outras intervenções. Cabe observar que os resultados centrais do nosso estudo usam apenas dados agregados de um longo período de tempo. Para implementar de forma satisfatória essa análise que leva em conta a evolução temporal das variáveis há, no entanto, um desafio substancial de modelagem já que uma boa modelagem de curvas pandêmicas pode requerer um número grande de parâmetros e, dado que o número de países é pequeno, modelos com muitos parâmetros podem gerar problemas de overfitting na hora da estimação. Optamos então por fazer algo mais simples e comum em estudos dessa natureza que é considerar os dados agregados no tempo.

5. O estudo que pretende nos refutar

O novo estudo que pretende nos refutar ataca o fato de termos usado dados agregados no tempo e se propõe a mostrar que a explicação para nossos resultados é justamente a causalidade reversa discutida acima. Adicionalmente, segundo o estudo, uma vez que uma análise que leva em conta a evolução temporal das variáveis é feita, encontra-se evidências de que as máscaras de fato reduziram a mortalidade. Se os argumentos e análises desses autores de fato mostrassem isso, eu não teria problema algum em admitir. Eu de fato não sei qual é a explicação para a associação positiva entre máscaras e mortalidade que encontramos e se alguém descobrir uma explicação que não envolva máscaras aumentando a mortalidade, fico feliz em saber a resposta. Isso não provaria que nós somos idiotas que não sabem analisar dados, é algo perfeitamente normal na Ciência que novas análises descartem hipóteses levantadas por estudos anteriores. O problema do artigo é que ele é um completo desastre de trem e nenhum de seus argumentos centrais para em pé. Abaixo discuto esses argumentos um a um. Vou ignorar os comentários inoportunos do artigo que misturam política com Ciência. Essa conversa não é sobre política.

5a. Argumento 1: gráficos da evolução do uso de máscaras nos 24 países (figuras 1A, 1B e 1C).

Tratam-se de gráficos da evolução do uso de máscaras apenas, sem comparação com mortalidade. Os gráficos mostram que o uso de máscaras variou muito com o tempo em diversos países, mas não ajudam em nada a avaliar a questão da causalidade reversa. O nosso artigo original já continha gráficos mostrando evolução do uso de máscaras juntamente com a evolução da mortalidade Covid e esses são obviamente muito mais úteis para avaliar a questão da causalidade reversa.

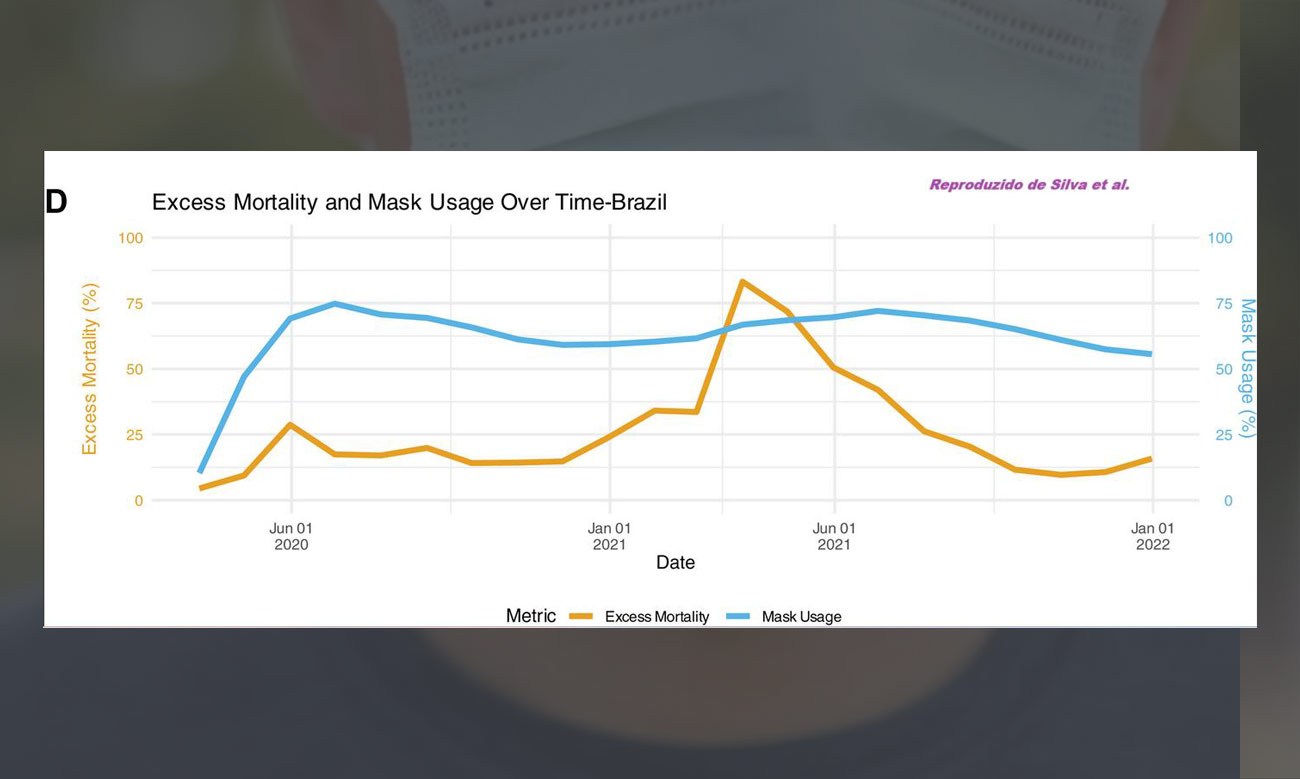

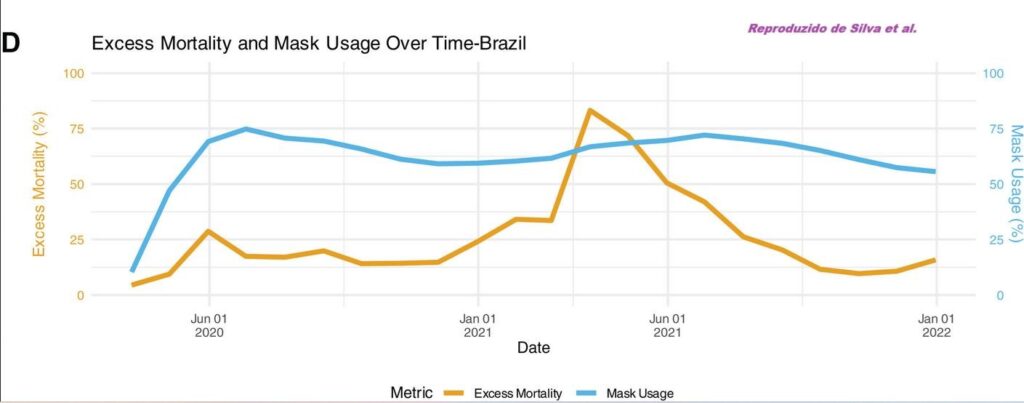

5b. Argumento 2: um gráfico da evolução do uso de máscaras junto com a evolução da mortalidade em excesso no Brasil (figura 1D).

Na primeira versão do artigo as legendas verticais desse gráfico estavam com as cores trocadas, de modo que dava a impressão que a curva azul que mostra a evolução das máscaras era na verdade a curva de mortalidade enquanto a curva laranja que mostra a evolução da mortalidade era na verdade a curva de máscaras. A legenda horizontal estava correta. Os autores parecem ter percebido o erro nas legendas verticais depois que informamos isso para a repórter do Jornal da USP e ela transmitiu a informação a eles. As cores já foram corrigidas na publicação. O gráfico corrigido está reproduzido aqui.

A questão da troca das cores é secundária, mas bom dia para você que acredita que peer review funciona muito bem – trata-se de um gráfico enorme, com um papel central no artigo e que tem um erro na legenda que atrapalha muito a interpretação. Ninguém viu. Imagina se algum referee iria conferir as análises e o código!

Vamos ao gráfico. Primeiro, é curioso usar um gráfico do Brasil para ilustrar um ponto quando o nosso estudo é sobre países europeus. As coisas lá na Europa poderiam bem ser diferentes daqui. O que é mais estranho, no entanto, é que o gráfico mostra exatamente o oposto do que os autores dizem que ele mostra. O gráfico mostra que o mascaramento se manteve quase constante ao longo da pandemia – exceto, obviamente, que antes da pandemia ninguém usava máscaras então logo no início do período o mascaramento sobe a partir de quase zero (o gráfico é suavizado por média móvel de 30 dias). O declínio do uso de máscaras no intervalo entre a primeira e a segunda onda é bem modesto. O que é notável, no entanto, é que enquanto a segunda onda foi extremamente mais letal do que a primeira (variante gamma, lembram?), o mascaramento na segunda onda é igual ao da primeira onda ou até ligeiramente menor. É um mistério como alguém achou que esse gráfico serviria como evidência da causalidade reversa.

5c. Argumento 3: análise estatística formal do efeito das máscaras sobre a mortalidade nos 24 países europeus, levando em conta a evolução temporal.

Essa é a análise mais importante do artigo. Embora não seja uma tentativa de prova direta da causalidade reversa, se uma análise tempo-dependente razoável mostrasse algum benefício das máscaras, seria um argumento muito forte de que a nossa análise agregada no tempo é problemática. Só que a análise apresentada está totalmente furada. Explicamos isso com todos os detalhes aqui (veja também aqui para os plots de resíduos mencionados no texto). Segue abaixo um breve sumário da explicação. O leitor interessado em compreender a questão em detalhes deve ler o texto completo.

Explicando de forma bem resumida, os autores usam um modelo linear (two-way fixed effects model) para avaliar o efeito do uso de máscaras numa semana dada qualquer sobre o valor de uma certa variável resposta um certo número de semanas após a semana dada.

Numa das análises, a variável resposta é a mortalidade em excesso semanal e na outra análise a variável resposta é a mortalidade em excesso acumulada desde o início de 2020. Na análise mais natural em que a variável resposta é a mortalidade em excesso semanal, a estimativa pontual do coeficiente do modelo é positiva, sugerindo que mais máscaras estão associadas a mais mortes algumas semanas depois. Porém, o resultado não é estatisticamente significativo e a incerteza é grande. É apenas na análise mais artificial em que se considera a mortalidade cumulativa desde o início de 2020 como variável resposta que eles encontram um benefício das máscaras (estimativa pontual negativa do coeficiente, estatisticamente significativa). Nessa análise com a mortalidade cumulativa, está se considerando o efeito do mascaramento numa dada semana na mortalidade em excesso num período que inclui uma quantidade enorme de tempo que antecede a semana em questão: por exemplo, considera-se o efeito do mascaramento na semana número 40 de 2020 na mortalidade em excesso no período que vai desde a semana número 1 de 2020 até a semana número 43 de 2020. Usando o mesmo modelo e código disponibilizado pelos autores, nós analisamos o efeito das máscaras na mortalidade em excesso nesse período que precede o mascaramento (semana 1 a 39 de 2020, no exemplo) e nós descobrimos que o efeito encontrado é quase o mesmo que o efeito encontrado pelos autores (tanto estimativa pontual como intervalo de confiança). Em outras palavras, o efeito que eles encontraram é na verdade um efeito espúrio do uso de máscaras sobre a mortalidade em excesso acumulada no período prévio ao mascaramento. Esse não pode ser um efeito real das máscaras que certamente não salvam vidas no passado!

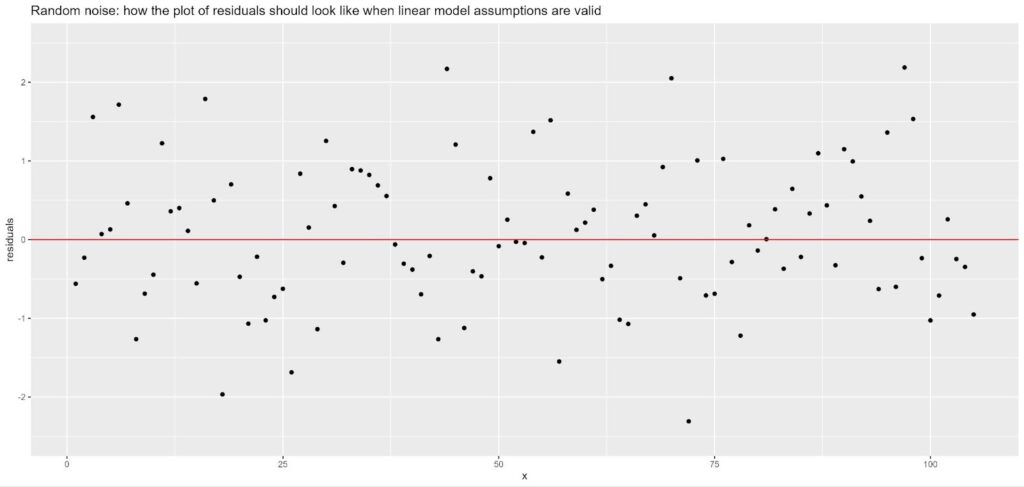

Mas a coisa fica ainda pior: o modelo utilizado por eles nessa análise tem hipóteses pouco realistas e usando uma técnica elementar de diagnóstico verificamos que as hipóteses são grosseiramente violadas. A técnica de diagnóstico em questão é simplesmente um plot de resíduos, algo que todo mundo aprende nos cursos básicos que deve ser inspecionado para se verificar a validade das hipóteses de um modelo linear. Esse plot deveria parecer com ruído aleatório flutuando em torno de zero se as hipóteses do modelo fossem satisfeitas, como ilustrado na imagem abaixo:

No entanto, o que vemos é algo completamente diferente: uma curva bem estruturada que não se parece em nada com ruído e que não flutua em torno de zero (confira os gráficos de resíduos do modelo deles aqui).

5d. Argumento 4: análise estatística formal da associação entre o Oxford Strigency Index e o uso de máscaras, levando em conta a evolução temporal.

Eu não verifiquei se essa análise tem problemas, é bem possível que ela sofra dos mesmos problemas de modelagem discutidos no item 5c acima, porém pouco importa. O Oxford Stringency Index é uma medida da intensidade de intervenções não farmacêuticas (como lockdowns, fechamento de bares, escolas, etc). O fato de ele estar positivamente associado com uso de máscaras é quase uma tautologia e nada de relevante segue daí. Se eles pretendiam demonstrar que o uso de máscaras aumenta como resultado de mais infecções ou mortes, poderiam ter analisado essa questão diretamente em vez de tentar usar esse proxy que não funciona de fato como um proxy.